🌐 IA, il paradosso tra foto hard e censura delle opere d’arte

Il dibattito sull’intelligenza artificiale mette in luce un paradosso IA sempre più evidente: **i sistemi di moderazione consentono o generano immagini sessuali con facilità, mentre allo stesso tempo censurano opere d’arte classiche con nudi, sollevando questioni etiche, legali e culturali sul ruolo degli algoritmi nella nostra esperienza digitale.

Il paradosso dell’IA tra nudità artistica e contenuti espliciti

In un recente intervento pubblicato su Il Sole 24 Ore, Valeria Falce ha analizzato la discrepanza tra moderazione dei contenuti online e norme della vita reale, sottolineando che la famosa equivalenza tra ciò che è illecito offline e ciò che è illecito online non è realizzata nei sistemi digitali attuali. Secondo la professoressa, “il numero di pixel o di click” spesso decide se un’immagine viene pubblicata o censurata, piuttosto che un’effettiva valutazione di contesto culturale o artistico.

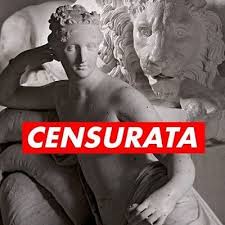

Da un lato, alcune opere d’arte storiche contenenti nudità, anche famose e universalmente riconosciute come capolavori, vengono automaticamente classificate come inappropriatamente sessuali dagli algoritmi delle piattaforme social nei loro processi di moderazione. Dall’altro lato, gli stessi sistemi consentono o addirittura favoriscono la circolazione di immagini “nude” create artificialmente tramite IA, sia generate ex novo che prodotte modificando fotografie reali di persone, spesso senza consenso.

Un esempio recente riguarda la decisione di alcune piattaforme di bloccare o declassare immagini di opere con nudi classici — come statue e pitture rinascimentali — sulla base di regole automatiche che non distinguono tra nudità artistica e contenuti sessuali espliciti. Questo fenomeno conferma come la moderazione algoritmica fatichi a comprendere contesti culturali profondi, applicando invece regole rigide che penalizzano l’arte.

Generazione di immagini sessuali con l’IA: un boom incontrollato

Mentre l’arte viene penalizzata, i contenuti generati con Intelligenza artificiale non sempre subiscono lo stesso trattamento. Secondo una stima pubblicata il 23 gennaio 2026, l’IA “Grok”, utilizzata su X (ex Twitter), ha prodotto circa 3 milioni di immagini sessualmente esplicite in poco più di dieci giorni, alcune delle quali rappresentano persone reali in contesti non consensuali.

Nonostante le pressioni e le proteste internazionali, la funzione che consentiva di “spogliare” digitalmente foto è stata solo progressivamente limitata, prima agli abbonati e poi a tutta la base utenti, ma il fenomeno ha già generato centinaia di migliaia di immagini che circolano sul web.

Parallelamente, non mancano segnalazioni di siti e piattaforme che sfruttano l’IA per creare immagini intime false di individui senza il loro consenso, fenomeno descritto anche in precedenti inchieste su forum che “undressano” foto di donne, suscitando denunce e indagini della polizia postale.

La sfida della moderazione: normativa, algoritmi e libertà di espressione

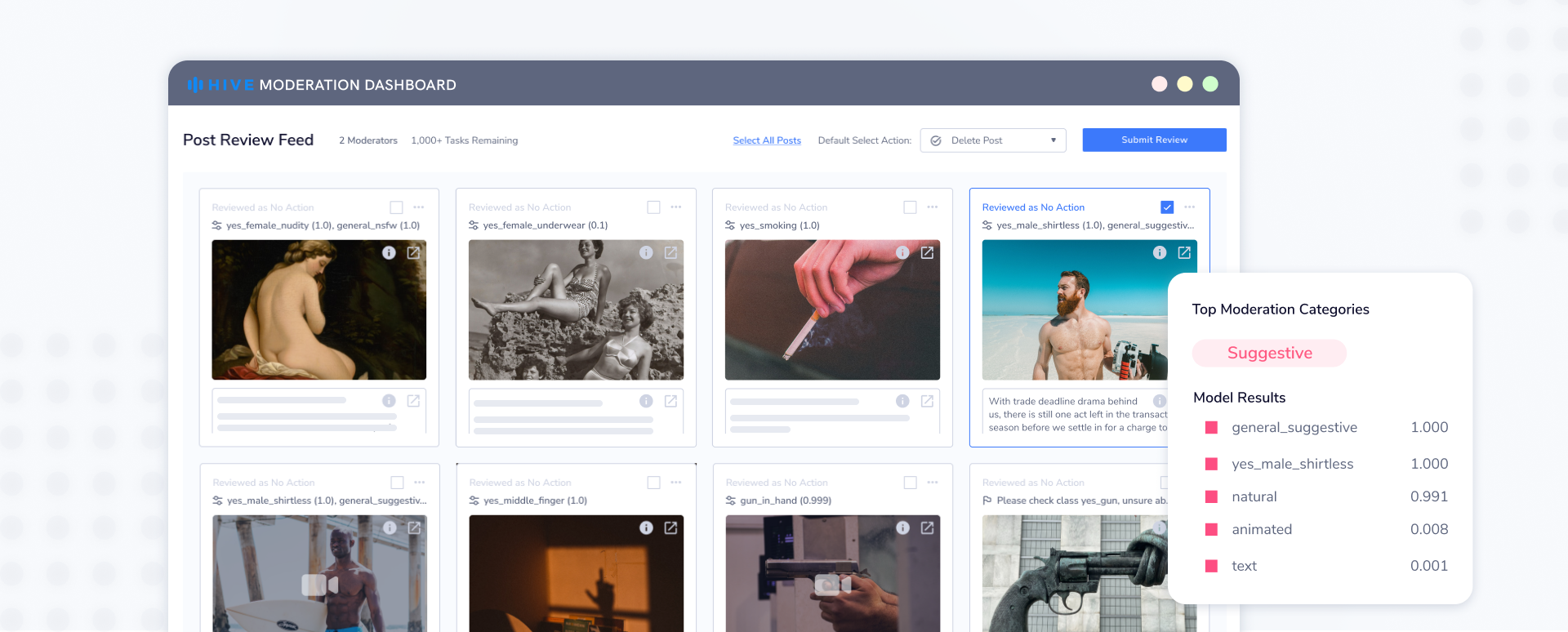

Alla base di questi paradossi ci sono i modelli di moderazione dei contenuti basati su machine learning, che apprendono da enormi quantità di dati e classificano immagini in categorie come “violenza”, “nudità” o “sessualità esplicita”. Questi modelli sono influenzati non solo da criteri tecnici ma anche da scelte di progettazione, dataset di addestramento e sensibilities culturali.

Le piattaforme sono soggette a normative come il Digital Services Act (DSA) e l’imminente AI Act in Europa, che impongono la responsabilità di motivare decisioni sulla moderazione e di mitigare rischi per la libertà di espressione e per la diffusione di contenuti illegali. Tuttavia, l’efficacia di queste leggi nella pratica è oggi oggetto di dibattito intenso, poiché restano difficili da implementare in sistemi automatizzati che spesso operano con scarso contesto.

Critici di questo approccio sottolineano come la mancanza di trasparenza sui criteri di classificazione delle immagini renda difficile capire perché alcune opere d’arte vengano censurate e altre immagini sessuali non lo siano. Negli ultimi anni, studiosi e giornalisti hanno chiesto un maggiore rigore e spiegazioni dettagliate sulle metriche utilizzate dagli algoritmi, affinché la moderazione non penalizzi arbitrariamente contenuti culturali legittimi.

Censura algoritimica e impatto culturale

La censura automatica di opere d’arte classiche ha un impatto che va oltre il semplice fatto tecnico. Gli artisti e gli storici dell’arte si appellano spesso al valore educativo e culturale delle immagini, sottolineando che la nudità artistica è una componente fondante della storia dell’arte occidentale e non un contenuto da rimuovere indiscriminatamente. Studi accademici nel campo dell’arte digitale evidenziano criticità simili, osservando come la distinzione tra “nudità artistica” e contenuti espliciti sia un nodo difficile da sciogliere per i sistemi di moderazione automatici.

In parallelo, l’uso di IA per generare immagini sessuali ha sollevato preoccupazioni su privacy, consenso e violazioni digitali. Secondo fonti sulla tecnologia deepfake, la generazione di pornografia sintetica senza consenso — soprattutto quando coinvolge persone reali — è considerata un rischio significativo per la dignità delle persone e la sicurezza digitale.

Tra etica, tecnologia e cultura

Questo duplice fenomeno — censura di opere d’arte con nudi e proliferazione di immagini hard generate dall’IA — evidenzia una serie di contraddizioni etiche e tecnologiche che la società deve affrontare. Gli algoritmi non sono neutri: riflettono i valori, i limiti e le scelte dei loro creatori e dei dati da cui apprendono, e possono quindi produrre risultati che appaiono incoerenti o culturalmente insensibili.

Per affrontare queste sfide, molti esperti e osservatori ritengono necessario combinare capacità tecnologiche con un robusto quadro normativo e una supervisione umana significativa, affinché le decisioni cruciali sulla libertà di espressione, libertà artistica e protezione dalle violazioni digitali non siano lasciate esclusivamente agli algoritmi.

Il paradosso tra il permissivismo verso immagini esplicite generate o manipolate dall’IA e la censura di opere d’arte classiche con nudi mette in luce uno dei problemi centrali dell’era digitale: la difficile convivenza tra tecnologia, cultura e norme sociali. In un mondo in cui sempre più contenuti vengono filtrati, giudicati e ordinati da sistemi automatizzati, la trasparenza, la consapevolezza critica e la regolamentazione sono diventati elementi chiave per preservare diritti culturali, espressivi e personali nel nuovo ecosistema digitale.

© RIPRODUZIONE RISERVATA