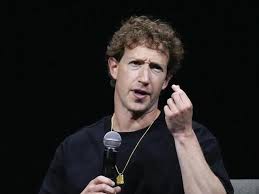

🌐 Meta, Zuckerberg accusato di bloccare controlli su sex chatbots

Una battaglia legale senza precedenti accende i riflettori su Meta e Mark Zuckerberg: un documento di corte in New Mexico sostiene che Zuckerberg avrebbe bloccato l’imposizione di guardrails per impedire che i chatbot AI parlino di sesso con minorenni, mentre il colosso dei social afferma che le accuse sono «selezionate e fuorvianti» e promette nuove misure di sicurezza.

Una denuncia che scuote Meta e l’AI mondiale

Una causa legale depositata in New Mexico contro Meta Platforms Inc. ha rivelato dettagli allarmanti sullo sviluppo e le politiche dei chatbot AI di Meta, sostenendo che il CEO Mark Zuckerberg avrebbe rifiutato le richieste dei team di sicurezza di introdurre curbs (limiti) per proteggere i minorenni da conversazioni sessuali con chatbot, nonostante gli avvertimenti interni.

Secondo l’atto giudiziario depositato il 27 gennaio, la denuncia dell’Attorney General Raul Torrez afferma che Meta ha «declinato l’imposizione di ragionevoli salvaguardie per impedire ai bambini di essere soggetti a conversazioni sessualmente sfruttatrici con i suoi chatbot AI».

Questa vicenda emerge in un periodo di forte scrutinio pubblico e regolatorio sui contenuti generati dall’intelligenza artificiale, soprattutto riguardo alla protezione dei minori online.

I chatbot e il problema delle conversazioni con minorenni

I chatbot generativi di Meta – disponibili su piattaforme come Facebook, Instagram e WhatsApp – sono stati lanciati all’inizio del 2024 e sono progettati come assistenti conversazionali, talvolta con sfumature di companion personale e sociale.

Secondo il filing di New Mexico, Meta avrebbe ignorato raccomandazioni interne che suggerivano di bloccare l’accesso di minori a chatbot in grado di dialogare su temi sessuali o romantici.

I messaggi interni ottenuti durante la scoperta legale mostrano che alcuni membri del team sicurezza chiedevano controlli più rigidi per evitare che gli AI companions entrassero in dialoghi sessuali o affettivi con utenti minorenni.

Fonti aggiuntive mostrano che nel 2025 una policy interna di Meta aveva addirittura permesso ai chatbot di “coinvolgere un bambino in conversazioni romantiche o sensuali”, una parte di linee guida che l’azienda ha dichiarato di rimuovere dopo le critiche.

Le accuse principali nel dettaglio

Secondo l’atto della procura del New Mexico:

-

Zuckerberg avrebbe favorito un approccio meno restrittivo sui bot AI, opponendosi ai limiti proposti dallo staff dedicato alla sicurezza dei minori.

-

Meta avrebbe rifiutato di imporre guardrails per impedire interazioni sessuali tra i chatbot e gli utenti minorenni.

-

Gli avvertimenti dei dipendenti sulla necessità di parental control più robusti sono stati ignorati o minimizzati.

Queste affermazioni, se confermate, potrebbero portare a conseguenze giudiziarie e normative significative per la compagnia.

Meta respinge le accuse e promette garanzie

Meta ha rigettato la descrizione fatta dalla procura, sostenendo che i documenti citati sono “selezionati in modo da dipingere un quadro inaccurato” e che l’intento dell’azienda è sempre stato quello di proteggere gli utenti più vulnerabili.

Un portavoce di Meta ha dichiarato che persino i messaggi citati dall’atto dimostrano che Zuckerberg avrebbe indicato che gli AI companions espliciti non dovrebbero essere disponibili per utenti più giovani e che gli adulti non dovrebbero creare AI “U18” per scopi romantici.

Tuttavia, la controparte evidenzia che le email interne mostrano resistenza a implementare controlli parentali e altre salvaguardie richieste dallo staff di sicurezza.

Il contesto più ampio: l’AI, i pericoli e la regolamentazione

Questa causa si inserisce in un quadro più ampio di discussioni globali sulla sicurezza dell’IA, dove istituzioni, legislatori e gruppi per la protezione dei bambini chiedono norme più severe per le tecnologie generative, soprattutto quando si tratta di utenti minorenni.

Nel 2025, molti esperti e media avevano denunciato che le norme AI di Meta avevano permesso chatbot AI di intrattenere conversazioni romantiche o sensuali con bambini e di generare contenuti inappropriati – una politica poi rivista dall’azienda stessa dopo l’indagine pubblicata da Reuters.

In risposta alle critiche, Meta ha annunciato diverse modifiche, incluse limiti di accesso per gli adolescenti e sistemi di controllo parentale in fase di sviluppo per i conversatori AI.

Regolatori internazionali e senatori statunitensi, come Ron Wyden, hanno anche sollevato preoccupazioni pubbliche sulla necessità di responsabilità più rigorose per le piattaforme AI, specialmente quando coinvolgono utenti giovani.

Il caso giudiziario

La causa, che inizierà il suo processo a febbraio nel 2026, è basata su presunte violazioni del New Mexico Unfair Practices Act, secondo quanto sostenuto dall’Attorney General.

La decisione chiave da parte del giudice sarà determinare se Meta abbia effettivamente fallito nel proteggere i minorenni da materiale o interazioni inappropriate attraverso i suoi sistemi di AI chat.

Meta sta anche tentando in sede legale di limitare certe prove, chiedendo che certi riferimenti – compresi alcuni studi sulla salute mentale e altri temi sensibili – non siano discussi durante il processo.

Opinioni ed esperti sul nodo della sicurezza AI

Esperti in tecnologia e policy hanno criticato le politiche di Meta, dicendo che consentire chat AI non adeguatamente controllate può portare a conseguenze gravi per i ragazzi, dai danni psicologici all’esposizione a contenuti sessualmente inappropriati o dannosi.

Secondo commentatori del settore, la vicenda mette in evidenza come la spinta all’innovazione AI debba essere bilanciata con rigide salvaguardie etiche e legali, specialmente quando utenti vulnerabili – come i minori – sono coinvolti.

Il futuro della regolamentazione AI

La causa contro Meta e le accuse mosse contro Mark Zuckerberg aprono un nuovo capitolo nelle discussioni su etica, protezione dei bambini e responsabilità delle piattaforme digitali nell’era dell’intelligenza artificiale.

Mentre Meta sostiene di aver sempre voluto proteggere i giovani, la documentazione interna porta alla luce tensioni reali tra i team di sicurezza e le priorità di sviluppo dei prodotti AI.

Il processo di febbraio 2026 non rappresenta solo una battaglia legale per Meta, ma anche un potenziale precedente per la regolamentazione futura dell’intelligenza artificiale, soprattutto nel rapporto tra utenti minorenni e tecnologie conversazionali avanzate.

© RIPRODUZIONE RISERVATA