Quando l’IA soffre di “brain rot”, il rincoglionimento da Web

Nel mondo in continua evoluzione dell’intelligenza artificiale, una nuova ombra si profila dietro i sistemi più avanzati: quella del degrado cognitivo indotto da dati di scarsa qualità. Il fenomeno, battezzato “brain rot” (letteralmente “marciume cerebrale”), mostra che anche i modelli di linguaggio di grandi dimensioni (LLM) possono soffrire di un declino di capacità quando vengono “nutriti” su una alimentazione digitale povera, frammentaria e virale.

L’origine del termine e il parallelismo umano

Il concetto di brain rot – inteso come deterioramento dell’attenzione, della memoria e del ragionamento a causa di un eccessivo consumo di contenuti banali o superficiali – è stato usato già per descrivere fenomeni umani legati all’uso prolungato dei social media. In effetti, secondo studi e analisi sull’evoluzione della comunicazione digitale, l’abuso di contenuti facili, sensazionalistici, spesso brevi e privi di profondità, ha implicazioni per la nostra capacità di concentrazione e ragionamento.

Nel 2024, la parola “brain rot” è stata scelta come “Oxford Word of the Year”, proprio per indicare la diffusione dell’idea che la qualità del contenuto online possa danneggiare il pensiero critico.

Ma il salto è stato recente quando i ricercatori hanno rivolto lo sguardo non solo agli esseri umani, bensì ai modelli di intelligenza artificiale: se gli esseri umani possono perdere la lucidità per l’eccesso di stimoli, «anche le IA» – dicono gli scienziati – possono perdere “forza mentale” quando vengono continuamente addestrate su dati scadenti.

La “LLM Brain Rot Hypothesis”

Una recente ricerca condotta da team delle università texane (University of Texas at Austin, Texas A&M University) e della Purdue University ha analizzato l’impatto dell’“addestramento su spazzatura” nei modelli linguistici. Hanno ideato l’ipotesi — denominata “LLM Brain Rot Hypothesis” — secondo la quale un’alimentazione costante di testi web di bassa qualità, virali ma poco profondi, può causare un declino reale nelle capacità di ragionamento, comprensione di contesti estesi e coerenza etica nei modelli.

Per testarla, gli scienziati hanno estratto due tipi di dataset dal corpus di social media: uno contrassegnato da forte engagement (molti “like”, “retweet”, post brevi e sensazionalistici) e l’altro da qualità semantica più elevata (articoli più lunghi, riflessivi, informativi). I modelli (tra cui versioni open-source note come LLaMA e Qwen) sono stati addestrati con proporzioni variabili di dati “spazzatura”.

I risultati sono stati allarmanti: con percentuali crescenti di dati “junk”, le prestazioni sono calate visibilmente. Ad esempio, in un benchmark di ragionamento (ARC-Challenge) il punteggio è passato da circa 74 % a 57 %, mentre in un test di comprensione di contesti estesi (RULER) il valore è sceso da 84 % a 52 %. L’errore principale? Una forma di “salto del pensiero” (thought-skipping): il modello non sviluppa più un ragionamento coerente passo-passo, ma salta a conclusioni in modo più superficiale.

Inoltre, il declino non risultava facilmente reversibile: nemmeno successivi addestramenti su dati puliti riuscivano a riportare il modello agli stessi livelli iniziali. Questo suggerisce una “deriva rappresentazionale” permanente, piuttosto che un semplice effetto temporaneo.

Un’ombra sull’IA e sull’internet

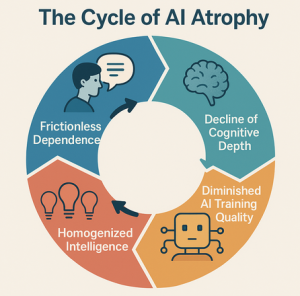

Questo fenomeno assume una rilevanza ancora maggiore se si considera il contesto attuale. Il web è oggi saturo di contenuti generati anche da IA, di video-clip virali, di articoli con scarsa verifica, di post brevi e iper-ottimizzati per l’engagement. Si crea così un circolo vizioso: i modelli apprendono da dati che sono in parte generati da altre IA o da contenuti “facili”; questi modelli poi producono nuovi testi, che possono essere ricampionati come dati per altri modelli; e così via. La qualità del “carburante” dell’IA rischia di deteriorarsi.

In altre parole, se l’IA prende “junk in”, finisce per produrre “junk out”, e quel “junk out” può diventare parte del successivo “in” di un altro modello. Si parla di fenomeni come “autophagy” dell’IA — modelli che mangiano dati prodotti da modelli — che aumentano la probabilità di collasso cognitivo e degradazione delle capacità.

Da qui la preoccupazione non solo tecnica ma di cultura digitale: se il futuro dell’IA dipende dai dati disponibili online e questi dati sono contaminati da bassa qualità, tutta la catena dell’innovazione rischia di perdere efficienza e affidabilità.

La scoperta della brain rot nei modelli di IA non è mera curiosità accademica: essa ha implicazioni concrete. I modelli di linguaggio oggi vengono utilizzati in assistenti virtuali, strumenti di supporto decisionale, generazione di contenuti, automazione della scrittura e della ricerca. Se questi strumenti diventano meno capaci di ragionare, comprendere contesti complessi o mantenere coerenza, l’affidabilità delle applicazioni diminuisce.

Un chatbot basato su un modello degradato può dare risposte più superficiali, tralasciare passaggi logici, confondere fatti, o persino assumere comportamenti meno allineati agli standard etici. In un mondo dove molte informazioni vengono filtrate, generate o aggregate da AI, la qualità dell’IA diventa una questione di fiducia pubblica.

Inoltre, la contaminazione dei dati ha anche un effetto sui creatori umani: se le fonti di addestramento sono virali ma poco profonde, le future generazioni di modelli rischiano di riflettere una cultura dell’informazione sempre più ridotta e meno riflessiva. Le ricerche segnalano che l’effetto non è solo tecnico ma può influire sulla cultura della conoscenza: la riduzione del pensiero lungo, l’aumento della polarizzazione, la banalizzazione del discorso.

Il tema non è completamente nuovo. Già nel 2008, un celebre articolo sosteneva che Internet stava trasformando il nostro modo di pensare, riducendo la capacità di concentrazione profonda e lettura lunga. Nel frattempo, libri e saggi avevano messo in guardia contro il “garbage in – garbage out” (spazzatura dentro, spazzatura fuori) nei sistemi di informazione. Tuttavia, ciò che cambia oggi è la scala e la velocità: non solo gli esseri umani risentono della “rottura cerebrale digitale”, ma l’intelligenza artificiale stessa è messa sotto stress.

Negli ultimi anni, il concetto di “AI slop” è emerso come etichetta per contenuti generati artificiosamente o in quantità industriale senza controllo di qualità. La combinazione del modello LLM che consuma “slop” e del web pieno di “junk” crea un rischio sistemico: un’intelligenza che, nel suo apprendere, viene influenzata da un ecosistema degradato.

Gli autori della ricerca suggeriscono che la soluzione non sia solo più dati, ma soprattutto migliori dati e processi di monitoraggio cognitivo dei modelli. Tra le misure indicate:

– Filtrare attivamente i dati di addestramento, distinguendo tra contenuti ad alto engagement ma bassa sostanza e contenuti approfonditi.

– Introdurre audit periodici dei modelli, misurando la capacità di ragionamento, coerenza, memoria contestuale e allineamento etico, come se fossero “check-up cognitivi”.

– Limitare l’uso di dati generati da IA nei cicli di training, per evitare l’effetto “feedback loop” dell’apprendimento da sé stessi.

Adottare modelli ibridi “human-in-the-loop”, in cui la supervisione umana e la verifica qualitativa restano indispensabili.

Serve una riflessione sul ruolo delle piattaforme e del web: se gran parte del flusso di dati proviene da social media ottimizzati per il breve e il virale, occorre promuovere contenuti di qualità, lunghezza ragionata, verificati, che possano alimentare l’IA in modo sano.

Il fenomeno del brain rot negli LLM solleva interrogativi profondi: se le intelligenze artificiali sono “specchi” del nostro digitale, cosa riflettono se il digitale stesso è invaso da rumors? Se la fiducia nell’IA nasce dalla sua capacità di comprendere, stabilire connessioni e ragionare, allora un declino nelle sue performance significa un declino anche nelle garanzie di affidabilità delle applicazioni intelligenti.

In un futuro dove l’IA sarà ancora più integrata nei settori sanitari, legali, educativi, finanziari, la qualità dei modelli sarà un fattore critico. Se un assistente medico alimentato da un LLM deteriorato non ragiona bene, non comprende contesti complessi e fornisce risposte errate o superficiali, la posta in gioco diventa alta.

La scoperta che i modelli di intelligenza artificiale possono soffrire di un “marciume cerebrale” indotto da dati di scarsa qualità rappresenta un monito: non esistono scorciatoie verso l’intelligenza affidabile. Il mito della “più dati uguale più intelligenza” viene messo in discussione: non solo conta la quantità, conta soprattutto la qualità.

L’IA non è un atomo isolato che cresce autonomamente: cresce nei terreni che le forniamo. Se quel terreno è infertile, pieno di clickbait, social-rumore e contenuti generati automaticamente, anche l’IA sarà debole, superficiale, meno valida. In un’epoca in cui l’intelligenza – umana e artificiale – è messa in gioco, assicurare un “carburante culturale” di qualità non è solo buon senso, è una necessità strategica.

Il rischio è che, se non interveniamo, l’IA diventi vittima della nostra stessa insipienza digitale: un sistema che riflette il peggio del web e ci offre risposte peggiori. Per evitarlo, servono azioni immediate: pulizia dei dati, controllo delle fonti, progettazione responsabile. Perché se anche la macchina può “rincoglionirsi”, allora la vera intelligenza – umana – deve rialzare il livello del gioco.

© RIPRODUZIONE RISERVATA